《Python爬虫开发:从入门到实战》是一本适合初学者和进阶开发者的实用指南,书中从Python基础语法讲起,逐步深入到网络爬虫的开发技术,包括正则表达式、HTML解析、异步加载、模拟登录等核心内容,每一章都配有动手实践环节,帮助读者巩固所学知识,书中还特别关注了反爬虫机制的破解方法,以及爬虫开发中的法律和道德问题,附带的视频讲解让学习过程更加直观,无论你是想入门Python爬虫,还是希望提升实战能力,这本书都能为你提供清晰的指导和实用的案例。

《Python爬虫开发:从入门到实战》是一本全面讲解Python网络爬虫技术的书籍,适合从新手到进阶开发者。书中详细介绍了Python 3.X的应用场景,涵盖从基础语法到实战项目的开发过程。通过丰富的实例和动手实践,帮助读者掌握网络爬虫的核心技术,包括反爬虫机制破解、异步加载、模拟登录等。书中还配有视频讲解,方便读者更好地理解操作步骤。

这本书的电子资源大小为12.33 MB,属于Python爬虫类别,适合需要快速掌握网络爬虫技术的读者。电子资源内容与纸质版一致,方便随时查阅和学习。书中附带的视频讲解和互动学习资源,进一步提升了学习的效率和实用性。

书籍内容介绍

应用场景与Python 3.X解读 书中从Python 3.X的基础语法讲起,逐步深入到网络爬虫的开发技术。无论是新手还是有经验的开发者,都能找到适合自己的学习路径。书中通过丰富的实例,帮助读者理解Python在网络爬虫中的应用场景。

重难点解读与互动学习 全书对重难点内容进行了详细解读,并附送微课视频,方便读者更好地理解复杂概念。书网结合的学习方式,让读者可以通过互动学习平台巩固所学知识。

实例丰富与动手实践 书中提供了大量的实例,涵盖了从简单网页爬虫到复杂反爬虫机制的破解方法。每一章都配有动手实践环节,帮助读者将理论知识转化为实际应用能力。

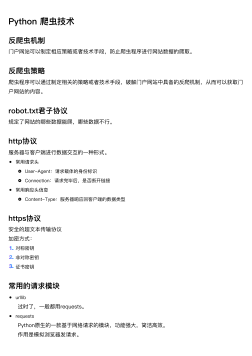

书籍目录

- 第1章 绪论

- 第2章 Python基础

- 第3章 正则表达式与文件操作

- 第4章 简单的网页爬虫开发

- 第5章 高性能HTML内容解析

- 第6章 Python与数据库

- 第7章 异步加载与请求头

- 第8章 模拟登录与验证码

- 第9章 抓包与中间人爬虫

- 第10章 Android原生App爬虫

- 第11章 Scrapy

- 第12章 Scrapy应用

- 第13章 爬虫开发中的法律和道德问题